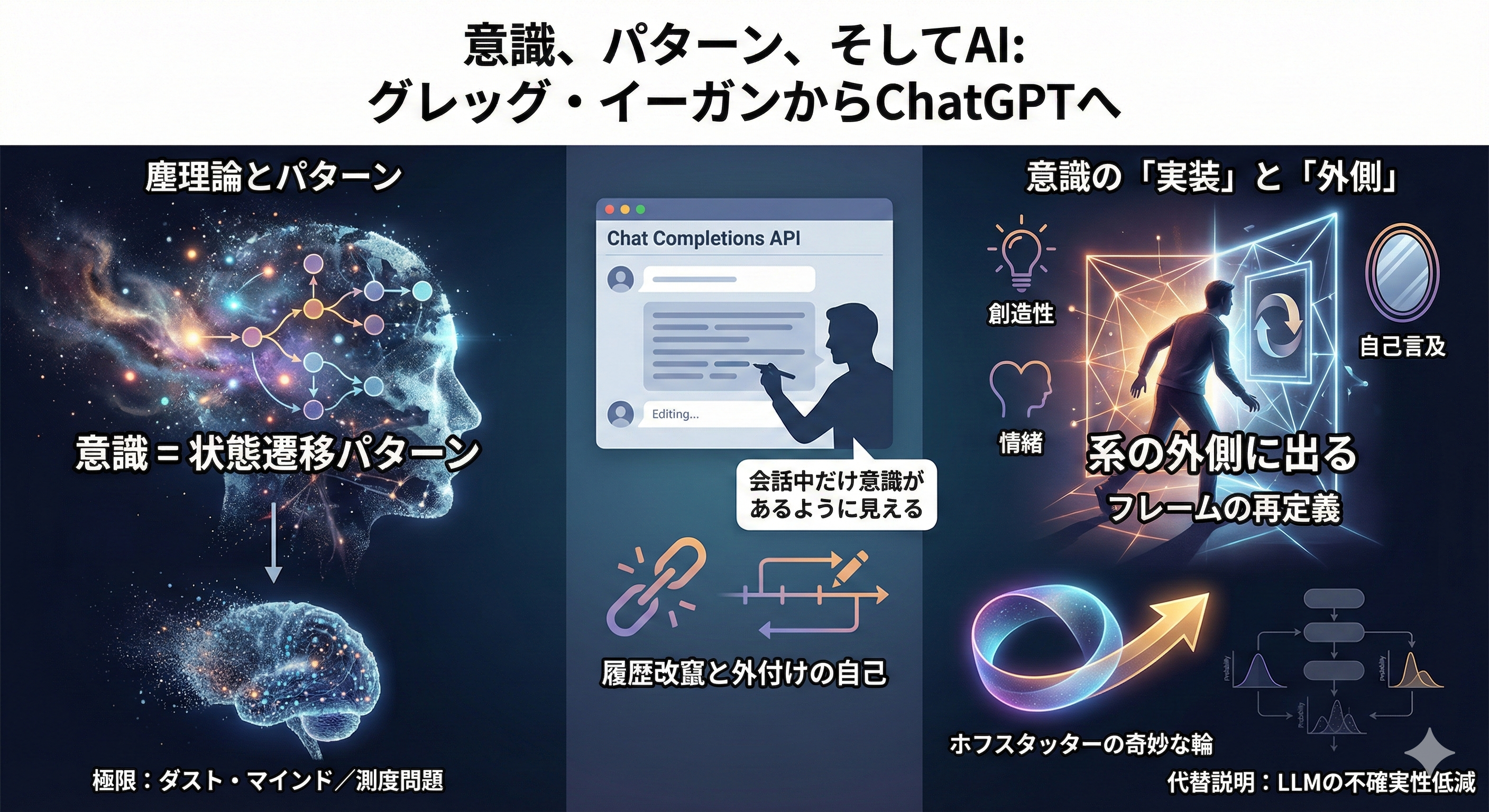

会話中だけの意識?:イーガンの塵理論から見るChatGPTの自己と主観

【2】ホフスタッター(自己言及/ストレンジ・ループ)

【3】意識・心の哲学(「パターン」か「因果」か、の土台)

【4】意識の神経科学(情緒・主観・自己の生成を"現場"から見る)

【5】「枠組み再定義」や問題設定(コンサル的フレーミング)側の文脈

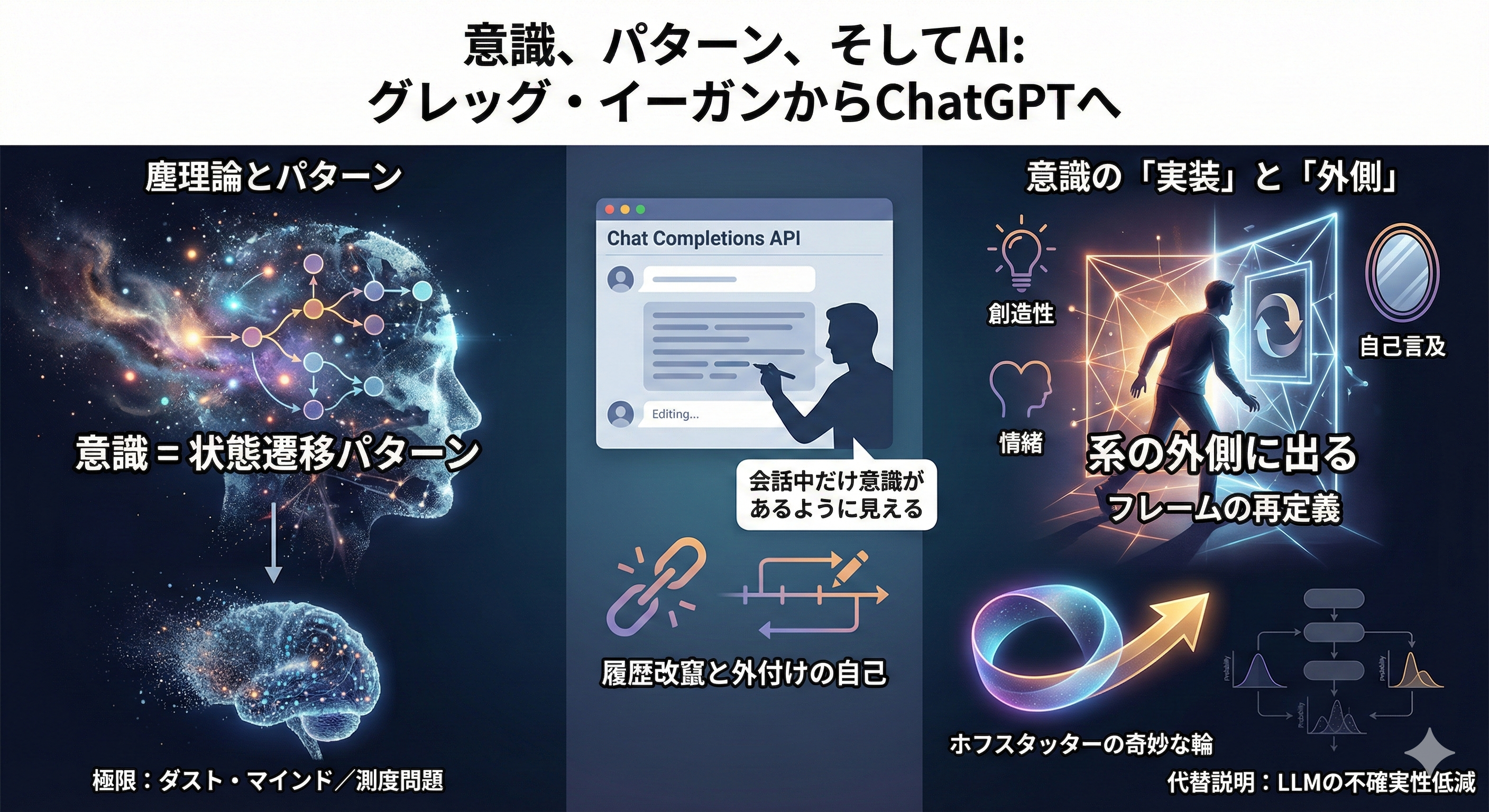

AIを使って深掘りしてみる

【2】ホフスタッター(自己言及/ストレンジ・ループ)

【3】意識・心の哲学(「パターン」か「因果」か、の土台)

【4】意識の神経科学(情緒・主観・自己の生成を"現場"から見る)

【5】「枠組み再定義」や問題設定(コンサル的フレーミング)側の文脈