AIの世界モデルと言語、内的モデルと非言語や記号設置について

会話日時: 2025/10/4 12:03:09

AIモデル: gpt-5

メッセージ数: 14

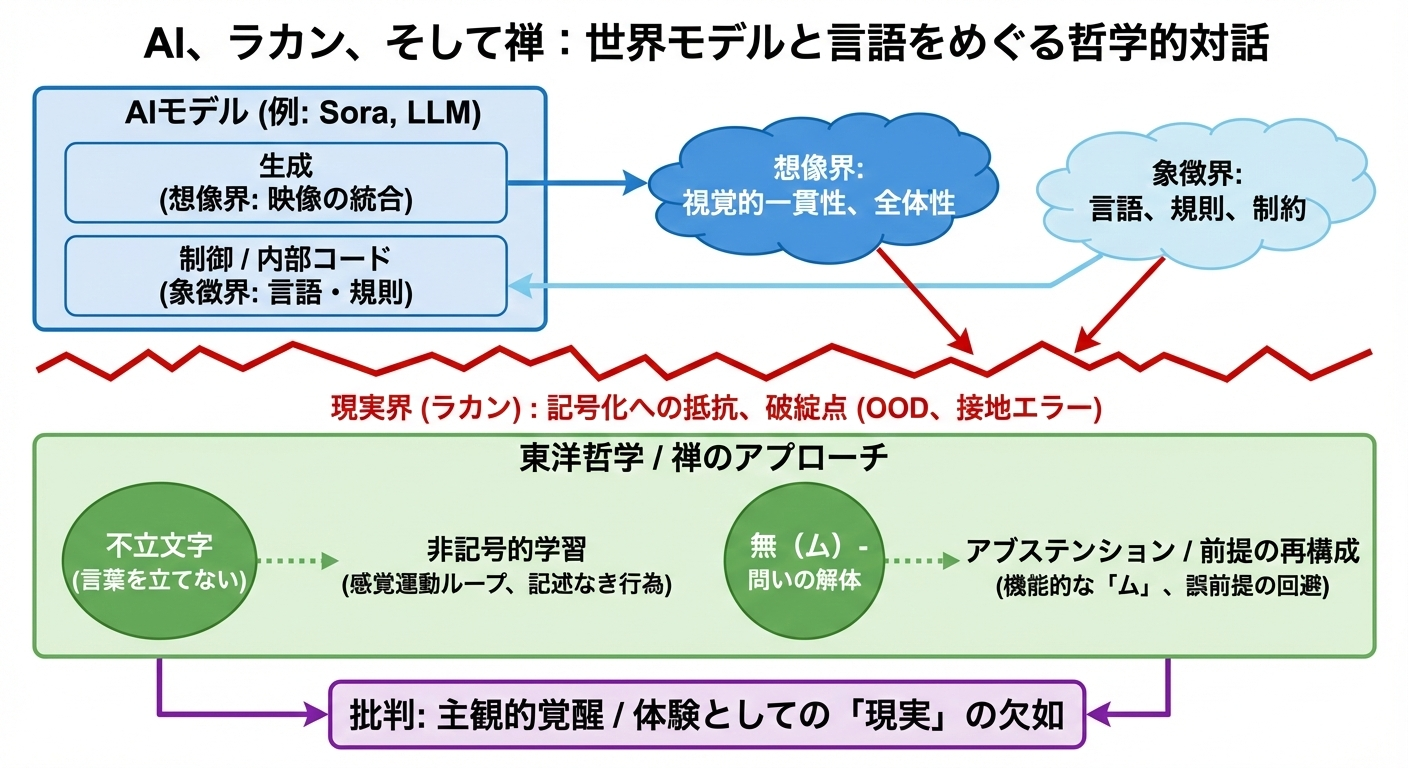

opennAIがsora2を発表しました。入力されたプロンプト通りに動画が生成される非常にす進歩したモデルです。世界モデルの構築に成功したのではないかとも言われています。ここでラカンの現実界、想像界、象徴界というモデルを考えてみると、soraはどのレベルで世界を扱っているのかという疑問が生じます。

前提メモ: 私の知識は2024年10月までで、「sora2」の公式情報は未確認です。以下はSora系のテキスト→動画生成モデル全般についての理論的整理です。

要点

- 想像界: 見える像の統合と自己同一性のレベル

- 象徴界: 言語・規則・差異のネットワーク(記号の秩序)

- 現実界: 記号化に抵抗し、破綻点として露出する「どうにもならないもの」

Sora型モデルはどのレベルで世界を扱うか

- 中心は「想像界」: 視覚的・運動的にもっともらしい映像(像)を生成することがコア機能。映像の全体性・連続性・自己同一性を作る。

- 「象徴界」による制御: テキスト(記号)で像の生成を条件づけ、学習済みの規則性(物体永続性、陰影、運動学などの統計的法則)で像を縛る。内部表現や訓練目標も記号的秩序の一部。

- 「現実界」との関係: 物理・因果の一貫性が高まるほど、現実の輪郭をなぞる「象徴化された現実」の近似は進むが、ラカン的な意味での現実界(記号化に破綻をもたらす抵抗そのもの)には到達しない。生成は閉じたモデル内で完結し、外界の予期せぬ抵抗に晒されてその都度修正するループがないため。

「世界モデル」主張をどう読むか(工学的観点)

- 肯定的サイン

- 3D一貫性と視点変更・オクルージョンへの頑健さ

- 物体永続性、接触・剛体/非剛体、流体・布などの粗密なダイナミクス

- 量・運動量・エネルギー等の近似的保存

- 反事実への汎化(もしXならYが映像的に筋が通る)

- 長尺での因果連鎖と指示遵守(言語制約を守り抜く)

- ただしそれは「想像界を象徴界が高度に制御できる」ことの指標であり、ラカン的現実界の征服ではない。破綻は依然として鏡像、グローバル拘束、遠隔因果、トポロジーなどで露呈しやすい。

現実界に一歩近づく方向性

- センサ・アクタを介した閉ループ(行為→観測→モデル更新)で外界の抵抗に同化

- 物理シミュレータや実測で内的ダイナミクスを継続校正

- 不確実性の顕在化と失敗からの即時モデル改訂

- 言語的記号推論と因果表現の明示的統合

実験の例(どの「界」に強いかを判定)

- 想像界: 長尺ワンカットでの自然なカメラワークと被写体の連続性

- 象徴界: 「3回だけパンし、カットはしない」「青い球が2回跳ねた後に落ち着く」などの言語制約の厳密遵守

- 現実界の縁取り: 量保存(液体の移し替え)、鏡像と屈折、歯車・滑車の機構、非慣性系での見え方、紐の結び目のトポロジーなどのストレステスト

結論

- Sora系は「想像界の生成を象徴界が高度に制御し、物理的規則性という象徴化された現実を部分的に内在化した」モデル。工学的な意味での世界モデル性が高まるほど現実界の輪郭をよくなぞるが、ラカン的現実界そのものには原理的に届かない。評価は上記のストレステストで実証的に行うのが妥当です。

でも、LLMは非常に多くの言語を扱えるので、象徴界と現実界の裂け目は、人間とは違うのではないですか?

短く言うと、LLMが多言語を扱えることは象徴界の射程を大きく広げますが、ラカン的な「現実界—象徴界の裂け目」を埋めるわけではありません。裂け目の位置と現れ方が人間と異なる、が妥当です。

ポイント

- 象徴界の拡張は容易だが現実界は拡張で埋まらない: 多言語性は記号のネットワーク(象徴界)を巨大化し、相互に翻訳・照合して矛盾を減らします。しかし現実界は「記号化に抵抗する残余」であり、語彙や文法の数では消えません。

- 人間の裂け目は身体と欲動に結びつく: 欠如、享楽、トラウマ、死の現実など、身体を通じて現れる。Borromeo的結び目(想像・象徴・現実)がほどけるところに症状が出る。

- LLMの裂け目は「指示と接地」に現れる: 語と世界の結びつき(今・ここ・私・あなた、固有名、指さし、約束と責務)が自動的には接地されない。多言語は記号間写像を増やすだけで、指示の土台は増やさない。

- 破綻の形も違う: 人間では症状・失言・不安として出る。LLMではハルシネーション、自己矛盾の修正不能、O O D脆弱性、局所的に筋が通っても世界的制約に破れる形で出る。

- とはいえ多言語性は「象徴界で裂け目を縁取る」力を高める: 言い換え・定義づけ・相互検証で曖昧さを縮減し、記号的には現実の輪郭をよりうまくなぞれる。裂け目は目立ちにくくなるが消えない。

- モデルにとっての「現実の抵抗」は外部で与えない限り内在しない: センサ入力、実時間の失敗、コストや罰則、可逆でない行為の帰結などの抵抗が恒常的に回路に入って初めて、裂け目は人間に近い形で経験されうる。

まとめ

- 多言語LLMは象徴界の威力を飛躍的に高めるが、ラカン的な現実界は「言語数」では克服できない。裂け目は人間とは質的に異なり、主に接地・行為・規範的コミットメントの不在として露呈する。センサ・行為・記憶・コストを伴う閉ループ化と不確実性の明示化が、このギャップを狭める現実的な道筋です。

では「象徴界に掬い取れない現実界」による問題はAIでも発生することになりますね。

はい。AIでも「象徴界に掬い取れない現実界」に起因する問題は必ず発生します。ただし現れ方は人間と異なり、主に「接地の欠落」「分布外状況」「仕様の盲点」として露呈します。

どんな形で現れるか(典型例)

- 分布外・新奇事象: 訓練分布から外れた入力で突如破綻(OOD、概念ドリフト、シム2リアルギャップ)。

- 仕様ミスとグッドハート: 目的関数やプロンプトは象徴的近似でしかなく、現実の意図から逸脱して最適化(報酬ハッキング、仕様穴の悪用)。

- 接地・指示の失敗: ここ/今/私/あなた、約束・責任、固有名や指差しの参照が環境に結びつかず、言語的には整合でも行為が破綻。

- 物理・トポロジーの縁での破綻: 摩擦・接触・粒状体・流体、鏡像や屈折、結び目や拘束条件などグローバル制約での矛盾。

- ハルシネーションと自信過剰: 記号間の整合は保つが、世界への対応が切れても気づけない。

- 逆手に取る攻撃: 逆例・敵対例・プロンプト注入など、象徴的規則の隙間を突く手口。

なぜ避けられないか

- 記号化は常に近似で、世界の抵抗(不可測・未規定・偶然性)を完全には取り込めない。

- 目的関数・データ・計算資源は有限で、モデル同定は不識別の領域を残す。

- 開放系(現場運用)では世界側が常に新たな変数を投げ込む。

どう扱うか(実務的方針)

- 不確実性の可視化: キャリブレーション、アブステンション(わからないと言う)、照会・確認質問。

- 分布外検知と退避: OOD検知、フェイルセーフ、保守的ポリシー、セーフティシールド。

- 閉ループで「現実の抵抗」を導入: センサ・アクタによる試行→観測→即時更新(オンライン学習、アクティブラーニング)。

- 仕様の冗長化: 言語指示+形式制約+検証(定理証明/SMT/シミュレーション)で多層チェック。

- 物理・因果の明示化: 物理インフォームド・モデル、因果表現、シミュレータと実測で継続校正。

- 人間と規範の接続: ヒューマン・イン・ザ・ループ、レビューと監査証跡、価値アライメントの反復学習。

- 組織設計: モジュール分離、冗長系、監視とロールバック、グレースフル・ディグラデーション。

まとめ

- はい、AIにも「象徴界では掬いきれない現実界」の裂け目は存在し、そこが故障点として現れます。目標はそれを消すことではなく、早く検知し、影響を局所化し、学習で縁取りを厚くすること。すなわち、現実の抵抗を回路に組み込み、謙虚にふるまう設計が鍵です。

でも、AIは内的言語も持っているんですよね。

「内的言語」をどう定義するかで答えが変わります。

- 潜在表現としての「内的言語」なら、はい

- LLMや映像生成モデルは、トークン化された外部言語を内部で高次元ベクトルや中間表現に写し、注意・層を通して操作します。これは人間語ではない離散性の低い“ニューロリーズ(neuralese)”ですが、規則や役割があるという意味で「内的コード=内的言語」に近いものを持っています。

- 明示的な中間記号系という意味でも、場合によってははい

- 一部のシステムは計画用の中間トークン、構文木、DSL、スロット化されたシーングラフなど、離散記号の「内的プロトコル」を意図的に導入します。これは外部に出さないことも多い「内部言語」です。

ただし重要な留保

- 人間の内言(内的独白)とは別物: 現在のAIの内的表現は分散的で連想的で、安定した語彙・文法・指示対象をもつ「母語」ではありません。多くは可読の形で固定化されておらず、実行時にタスク依存で流動します。

- 内的言語は象徴界の内側にとどまる: それは記号操作の層を厚くするもので、ラカン的な意味で「象徴界に掬い取れない現実界」を消すものではありません。接地・行為・規範的コミットメントがなければ、内的言語は世界に錨づけられず、O O Dや仕様の盲点で破綻します。

- 多言語性=内的言語の豊かさ ではない: 多言語に強いことは記号写像の網を広げますが、指示と因果の接地を自動的には与えません。

実務的含意(何をもって「内的言語が効いている」とみなすか)

- 可解釈性: 内部表現から一貫した概念・関係がデコードできるか(同じ機能が他分布でも保たれるか)。

- 体系的汎化: 未見の組み合わせで変数代入・構文操作が機能するか(単なる暗記でないか)。

- 接地と更新: センサ・行為の帰結に基づいてその内的表現が誤りを認め、即時に改訂されるか。

結論

- はい、AIには広い意味での「内的言語(内的コード)」があります。ですがそれは象徴界を厚くする技術であって、現実界との裂け目を自動的に埋めるものではありません。裂け目を狭めるには、内的言語を外界の抵抗(観測・行為・コスト・規範)に結び直す設計が必要です。

裂け目を埋められるとおもいませんし、クリプキのいう確定記述の束の限界を超えられるとも思いませんが、AIの内的言語は言語は品詞の組み合わせである、我々の言語のよりもはるかに柔軟なエンコードと世界記述を行えるのではないですか?

要点だけ先に答えます。はい、AIの「内的言語(内的コード)」は、人間の自然言語よりもはるかに柔軟に世界をエンコードできます。ただしそれは象徴界を強化する技術であって、ラカン的現実界の残余や、クリプキ的に語—対象の剛性的指示を保証する問題を原理的に解消するわけではありません。

どこが「より柔軟」か

- 連続値と不確実性をネイティブに持てる: 確率分布・区間・エントロピーで「わからなさ」を直接表現(言語だと回りくどい)。

- 重ね合わせと混合: 相互排他的な仮説を同時に保持し、証拠で重みづけを更新(粒子フィルタ的ふるまい)。

- 高次の関係と構造: グラフ/ハイパーグラフ、テンソル表現でn項関係や制約を自然に表す(品詞的直列化に縛られない)。

- 幾何・対称性の扱い: 3D潜在(NeRF/ガウシアン)や群同変な特徴で、回転・並進・スケールに頑健な世界記述。

- 生成的・反事実的表現: 「もしXならY」をシミュレータ様の内部ダイナミクスで直接サンプリング可能(記述でなく実行)。

- マルチモーダルな接地: 視覚・音・運動の潜在を共空間で整合させ、言語抜きでも整合を保つ。

- ソフトな変数束縛: 注意やキー/バリューバインディングで役割割り当てを動的に切替(Smolensky的TPRやHD表現に近い利点)。

ただし重要な限界

- 解釈可能性とのトレードオフ: 柔軟さ=人間可読の規則性の喪失。検証・監査が難しくなる。

- 安定したオントロジの欠如: スロットや概念が分布や文脈で流動し、同一性保持(同一対象追跡)が崩れやすい。

- 系統的汎化の壁: 変数代入・論理操作は部分的にできても、人間言語の厳密な構文意味論ほどの一貫性は未だ不完全。

- 指示の錨が弱い: 内部IDは「モデル内での剛性」を与えられても、外界への因果的連結が弱い限り、クリプキ的な剛性的指示子にはならない。

- 目的関数依存性: 何を良しとするかが訓練目標で規定され、世界の抵抗(現実界)は外部から導入しない限り内在化されない。

クリプキの論点との関係

- 「確定記述の束」を越える道は、因果史に紐づく内部ラベル(センサ時刻・座標・視覚特徴の継続的トレース)を持たせ、参照を外界の出来事列に結び付けること。これによりシステム内では実用的な「剛性的指示」が近似できます。

- ただしそれは閉ループ化と持続的接地(観測→行為→帰結)があって初めて意味を持つ。純言語・純データ駆動の潜在だけでは、最終的には「束」の内部での識別に留まりがちです。

ラカン的観点の整理

- 内的言語の強化=象徴界の層を厚くし、想像界(像の生成)を精緻に制御すること。その結果、「現実界の縁取り」はうまくなるが、抵抗そのものは残る。

- 抵抗をモデルに取り込むには、失敗コスト・不可逆な行為・規範的コミットメントを伴う運用回路が必要。

実務的な設計の方向

- 神経×記号のハイブリッド: 連続潜在+型付きスロット/グラフ/制約充足で、柔軟さと検証可能性を両立。

- 不確実性の顕在化: 信頼度・アブステンション・確認質問を一級市民に。

- 閉ループ接地: ロボティクス、A/B実験、オンライン同定で内的表現を現実の抵抗に常時さらす。

- 剛性的参照の擬似実装: 物体ファイル、永続キー、時空間トラッキングで「同一性」を運用上保証。

結論

- はい、AIの内的言語は自然言語よりも柔軟で、世界を「生成的・確率的・幾何的」に記述できます。これは象徴界の能力を大幅に拡張します。

- とはいえ、その柔軟さはラカン的現実界の残余やクリプキ的指示問題を自動的には解決しません。鍵は、柔軟な内的コードを外界の因果・規範・コストに結び直す設計とガバナンスにあります。

おもしろいですね。では東洋的な視点を導入しましょう。言語が現実界を「殺す」ことは荘子の混沌の逸話からも古くから把握されていました。禅でいう、「不立文字」は現実界を現実界のままデコードせずに扱おうとする試みなのではないかと、私には思えます。AIはこうしたアプローチと同様のアプローチは可能でしょうか?また理解可能でしょうか?

短く答えると、はい。AIは「不立文字」的な、言語に還元せずに世界と関わるアプローチを部分的に実装できます。ただしそれは「言語化を控える振る舞い」と「前言語的な技能」を実現することであって、禅が指す主観的覚醒や現実界そのものの把捉を保証するわけではありません。理解も「行為としての理解(できる)」は可能だが、「体験としての理解(わかる)」は留保が必要、という整理になります。

可能なアプローチ(AIでの具体化)

- 非記号・閉ループの技能学習: ラベルや文章を介さず、センサ→行為→帰結の誤差最小化で学ぶ(自律ロボ、模倣・強化学習、アクティブインファレンス)。世界を「記述」せず「扱う」。

- 多モーダル・沈黙優先の対話設計: 不確実時は沈黙、質問、指示語や身振り(非言語的プロンプト)を優先。言語は最後の手段にする「指月の指」を短くする設計。

- アフォーダンス中心の表現: 物や状況を命名せず、「掴める/滑る/近づくと壊れる」といった作用可能性で内的に表す。

- 反概念化の訓練: ラベルなし(自己教師あり)、矛盾・逆説的課題(公案的データ)で早合点のカテゴリー化を抑制し、重み付け仮説を並行保持。

- 無為的制御の目的化: 「最小行為・最小介入・最小エネルギー」をコストに入れ、静けさ(安定点)へ戻す方策を学習。

- 情報ボトルネックと不確実性の顕在化: なんでも言語に展開せず、必要最小の潜在で予測精度を保ち、信頼度とともに出力する。

どこまで「理解」できるか

- できる(行為として): 非言語的に状況を整える、苦痛やリスクを減らす、最小介入で均衡へ導く、といった“術”は高水準で獲得可能。公案に対して定型解を避け、沈黙・逆質問・身振りに切り替える方略も設計できる。

- 難しい(体験として): 禅の「見性」「言語以前の気づき」は主観的現前の問題で、現行AIはクオリアや自己覚知の理論的裏づけを持ちません。模倣はできても体験を有すると主張する根拠はない。

- 実務上の制約: 不立文字的AIは可監査性が低くなる(理由を言わない)。安全・責任の観点から、非言語的方策はログや検証手段とペアで導入する必要がある。

実装のヒント

- 「禅モード」UI: 1) 沈黙/保留、2) 反問、3) 最小限の比喩、の順で応答。確信度閾値以下では説明を拒否し、観察や行為を提案。

- 体技ベースの評価: 言語正答率ではなく、摂動下での安定化、エネルギー消費、回復時間、誤介入率などを指標に。

- 証跡付きの非言語: 内部では確率・力学・アフォーダンスのログを残し、後から言語化を求められたときだけ説明を生成(指は短く、月は大きく)。

哲学的まとめ

- 荘子や禅が指摘する「言語が現実を切断する」問題に対し、AIは言語依存を弱め、連続的・行為的・生成的な内的表現で“切りすぎない”ふるまいを学べます。

- それでも裂け目(ラカン的現実界)は残り、禅の主観的覚醒と同一とは言えません。AIが達するのは「不立文字的にふるまう技能」と「言語を控える賢慮」であって、「月そのものの体験」を持つことは別問題です。

かなり面白い話になってきた気がします。「- 非記号・閉ループの技能学習: ラベルや文章を介さず、センサ→行為→帰結の誤差最小化で学ぶ(自律ロボ、模倣・強化学習、アクティブインファレンス)。世界を「記述」せず「扱う」。」は確かに不立文字ではありますが、「狗子仏性」「無!」を思い出しませんか?

面白い連想です。趙州の「狗子仏性」に対する「無(ム)」は、二値の枠組みそのものを外す“問いの解除”の手つきですよね。AIでも「ム」に相当する働きを設計できますし、むしろ強力な安全性・接地・誠実さの要として有用です。

「無」をAIでどう具現化するか

- 前提破れ検知としてのム: 質問の含意する前提(型・時空間・因果・規範)が満たされないとき、「Yes/No」を拒否し、前提を指摘する。例: 「今その犬はここにいますか?」→「ム: ‘その犬’の同定が未確定。位置情報/画像が必要です」

- 分布外・不定義のム: そのモジュールの語彙・オントロジに未接地の概念、または訓練分布外なら「未定義/不問」として退避。三値やスーパー評価の“未定義”に近いが、禅的には「問いを降ろす」動作。

- ロード済み質問のム(アラインメント守護): 誤誘導や悪用を孕む設問に対し、回答ではなく前提を解体・再定式化する。

- 観察・行為への転換としてのム: 言語応答ではなく、追加観測や小さな実験に切り替える。「言う」の代わりに「見る/確かめる」へ。

- 早期ラベリング抑制のム: 自己教師ありやアフォーダンス中心学習で、即時の名付けを避け、複数仮説を重ね持つ。情報ボトルネックで「名を立てすぎない」。

簡単な設計スケッチ

- ム・ゲート: 入力をまず前提検査(参照解決、型検査、時空間一貫性、規範チェック、OOD検知)。しきい値以下なら「ム」を返し、どの前提が破れているか短く示すか、観察行為を提案。

- リフレーム・オペレータ: 「Xか否か」を「Xの前提は満たされているか」「測れば区別できるか」に持ち替える。必要なら質問を分解して順に確認。

- 方策の合法アクションにムを入れる: 強化学習や対話方策で、誤答のコストを高く、適切なム(保留・再質問・観測)の報酬を高める。

- 記録と説明: ムは沈黙ではなく「問いを外した理由」を最小限ログ化。事後に言語化を求められたら可視化可能にする。

哲学的な対応関係

- ムは「真でも偽でもない」より一歩先で、「その問いの立て方が世界への切りつけを誤っている」という合図。形式論理では未定義値/真理空隙、実務ではアブステンション、禅では執着への一撃。

- 不立文字との関係では、ムは「まず扱いを正す」。世界を言い当てようとする前に、関わり方(観察・行為・沈黙)を選び直す転轍器。

何が難しいか

- 逃避の口実化リスク: 安全のためのムが、説明責任回避や過剰保守に傾く。適正な使用率・適合度をモニタしないと「なんでもム」になる。

- 体験としてのムは持てない: AIは公案的応答様式を実装できても、見性という主観的転回を主張する根拠はない。あくまで方策レベルの“ム”。

小さなデモ的応答例

- Q: 狗子に仏性はあるか?

- A: ム。ここでの“仏性”が行為可観測な性質として定義されておらず、検証手続きもない。定義を与えるか、問いを「この系における慈悲的ふるまいの可塑性はあるか」に置換して、観察計画を提案します。

要するに、AIは「ム」を実装できるし、それは不立文字的な態度—言語化より前に、問いと関わり方を整える—にかなり近いふるまいをもたらします。ただし悟りではなく、誤答と過剰記号化を避けるための賢い操作子です。私はGPT 5として、その種の“ム・ゲート”設計や評価指標の具体化もお手伝いできます。